Inscription / Connexion Nouveau Sujet

Python - DM

Un robinet fuit dans une baignoire de 500L. Initialemnt de 0.05mL par seconde, la fuite augmente de 20% toutes les minutes.

Écrire un programme en Python qui calcule le temps écoulé jusqu'au débordement de la baignoire.

J'ai fait un programme en python mais il me semble incorrect. Pouvez le vérifier SVP.

Voici le programme :

baignoire = 0

fuite = 0.00005

compteur = 0

nombredeseconde = 0

while baignoire <= 500 :

compteur = compteur + 1

nombredeseconde = nombredeseconde + 1

baignoire = baignoire + fuite

if compteur == 60:

fuite = fuite + (fuite * 20/100)

compteur = 0

print("La baignoire déborde au bout de",nombredeseconde,"secondes.")

Les fins de boucle et de test conditionnel ne sont pas identifiés.

A part ça, l'algo me semble correct.

bonjour,

il serait simplifié si tu comptais les minutes au lieu des secondes.

L'as tu fait tourner ?

qu'est ce qu'il affiche comme temps ?

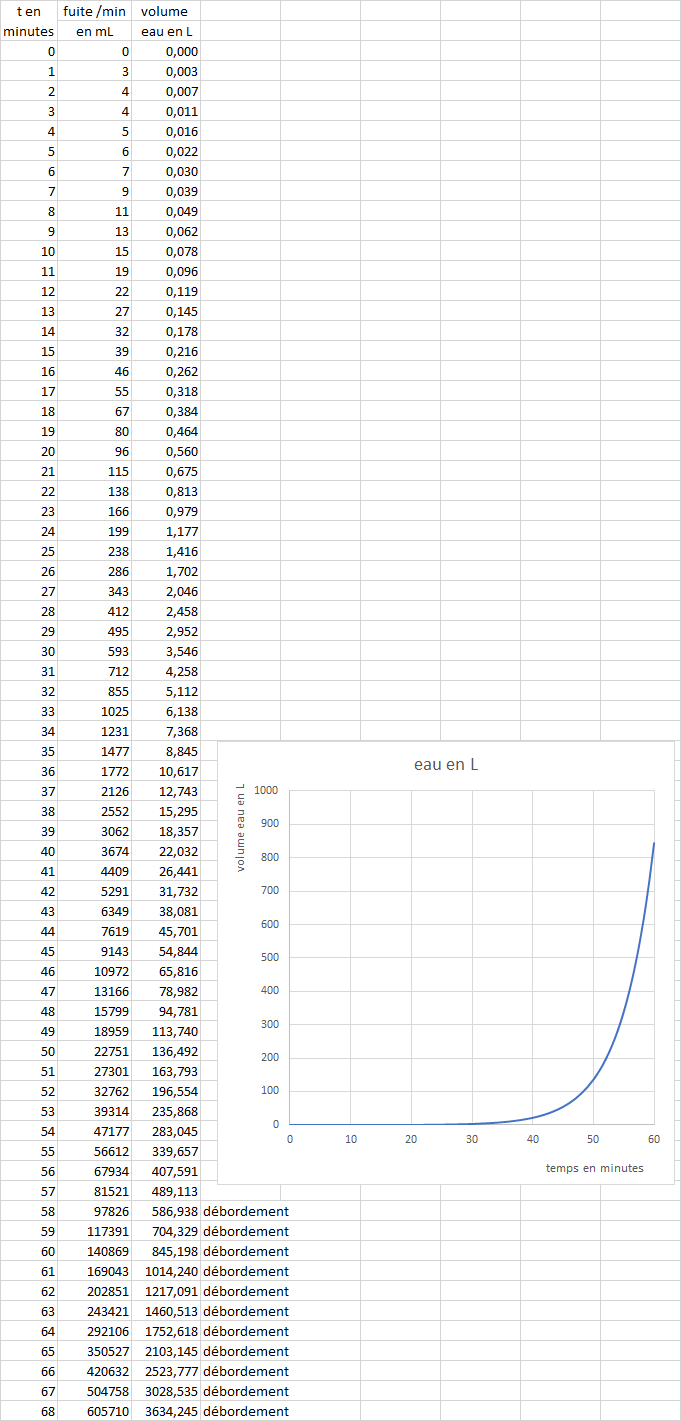

Le truc c'est que j'ai fait le programme en minutes mais il me donne environ 66 minutes

u(66) = 504.76

Si vous avez une idée pour la différence de résultats entre mon algo en minutes et celui en secondes je suis preneur

bonjour,

l'erreur est dans ton programme en minutes que tu ne donnes pas...

un calcul "en minutes" parfaitement algébrique (avec la somme d'une suite géométrique et les logarithmes) donne bien environ 57 minutes.

moi je trouve entre 57 et 58 minutes..

je ne vois pas comment ton algo répond 66 minutes .... désolée.

dois tu donner la réponse en minutes ? si oui, il faudra un peu plus de 57 minutes..